Introduction

최근 들어 Large Language Model(LLM)이 논리적이고 복잡한 문제를 푸는 능력이 크게 향상되었으나, 여전히 해결해야 할 이슈가 존재한다. 예컨대, 기존 접근법으로는 잘못된 중간 추론 단계가 최종 답안까지 이어질 위험이 크다. 이를 해소하기 위해, 본 논문에서는 DeAR(Decompose-Analyze-Rethink)라는 새 프레임워크를 제안했다. DeAR은 한 번의 Reasoning 루프에서 문제를 반복적으로 분해하고(Decompose), 해결한 뒤(Analyze), 기존 해결 과정을 재검토(Rethink)함으로써, 인간의 추론 과정과 유사하게 문제를 풀 수 있도록 지원한다.

Background

1) LLM의 추론 이슈

- Chain-of-Thought(CoT)이나 Tree-of-Thoughts(ToT)와 같은 기법으로 중간 추론 과정을 생성할 수 있게 되었으나, 아직도 잘못된 중간 논리가 최종 답에 반영되는 문제가 남아 있다.

- 특히, ToT와 같은 기법은 고정된 분기 수(Branch)와 깊이(Depth)에 따라 트리 형태로 여러 생각을 탐색하지만, 노드 간 정보 교환이 제한적이라 한번의 오류가 뒤까지 전파될 위험이 크다.

2) Decompose-Analyze-Rethink의 특징

- Decompose: 문제를 더 단순한 하위 질문들로 쪼갠다.

- Analyze: 각 하위 질문에 대한 해답(추론 과정)을 생성하며, 필요 시 Self-Check로 오류를 수정한다.

- Rethink: 새로 얻은 하위 질문의 결과가 상위 노드(이미 생성된 추론 결과)를 갱신해야 하는지 판단하고, 필요하면 상위 노드의 추론을 수정한다.

전반적 구조

Reasoning Tree

DeAR은 문제를 트리 형태의 Reasoning Tree로 표현한다.

- 루트 노드는 원 문제를 담고 있다.

- Decompose 과정을 통해 상위 노드의 질문이 여러 하위 질문으로 나뉘게 되고, 각 하위 질문이 새로운 노드로 형성된다.

- Analyze에서 하위 노드들에 대해 실제 추론(해답과 근거) 과정을 수행한다.

- Rethink에서 하위 노드 정보가 상위 노드를 재갱신할 필요가 있는지 확인하고, 필요하면 수정한다.

이러한 트리 구조가 깊어지고 넓어지며 전체 문제를 점진적으로 해결하게 된다.

핵심 아이디어: DeAR 사이클

DeAR 프레임워크는 크게 세 단계가 순환 구조로 작동한다.

- Decompose

- 이미 생성된 어떤 노드가 있고, 이 노드가 아직 완전한 해답으로 이어지지 않는다면, LLM이 스스로 “이 노드를 더 쪼갤 가치가 있는가”를 결정한다.

- 필요하다면, 해당 노드의 질문을 여러 하위 질문들로 분해하여 새 노드들로 추가한다. 이때 하위 질문 개수는 미리 정해두지 않고, LLM이 논리적으로 결정하도록 한다.

- Analyze

- 새로 생성된 하위 질문 노드마다, LLM이 답변(해답 및 근거) 생성을 시도한다.

- 이후 Self-Check 절차를 통해 해당 근거에서 오류를 수정하고, 이 답변이 얼마나 신뢰할만한지 점수화(Coherence Score)한다.

- Rethink

- Analyze에서 얻어진 하위 노드들의 결과를 기반으로, 상위 노드에 적힌 기존 해답을 재검토한다.

- 새 하위 노드 근거가 상위 노드의 답변을 뒤집거나 수정할 필요가 있다면, 상위 노드의 답변을 업데이트한다.

- 이렇게 하위에서 얻은 정확한 정보가 상위 노드에도 반영되어, 초기에 잘못된 상위 노드 추론이 있더라도 단계적으로 수정될 수 있다.

위 세 단계가 반복 수행되면서 전체 Reasoning Tree가 완성되고, 루트 노드(원 질문)의 최종 해답이 결정된다.

실험 및 결과

데이터셋

- ScienceQA: 과학 지식 기반 문제로 이뤄진 멀티플 초이스 QA.

- StrategyQA: 스스로 서브 질문을 구성해 추론해야 하는 논리 문제.

- GSM8K: 초중등 수준의 수학 문제. 다단계 계산이 필요하다.

비교 기법

- Few-shot: 예시만 덧붙인 일반적인 In-Context Learning.

- CoT: 단계별 중간 근거를 생성하나, 상위 노드 수정이 불가.

- ToT: 트리 구조를 탐색하지만, 오류 수정이 즉각적으로 반영되지 않음.

- GoT: 그래프 구조로 확장했으나, 여전히 상위 노드 업데이트가 제한적.

- DeAR: 본 논문에서 제안하는 Decompose-Analyze-Rethink 순환 구조.

주요 결과

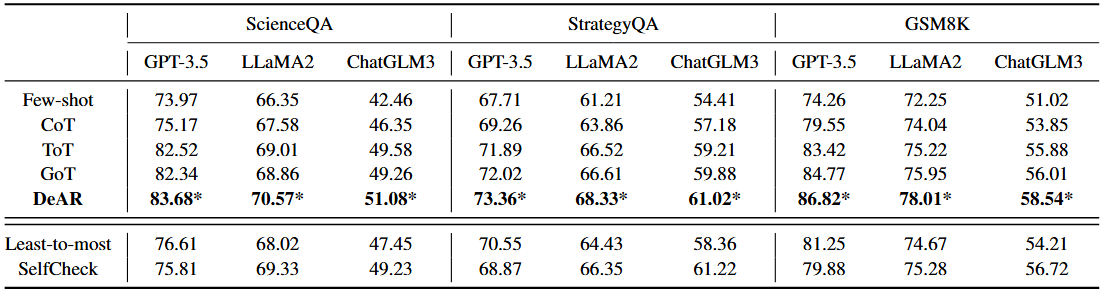

1) 성능 지표: 아래 표와 같이, DeAR이 ToT, GoT, CoT 등 기존 방법 대비 전반적으로 높은 정확도를 보였다.

2) 추론 논리 품질: ROSCOE 평가(논리적 합치도 측정)나 사람 평가에서 DeAR이 가장 논리적이라고 판단되는 경우가 많았다.

3) Rethinking의 성능 향상: DeAR은 Rethinking을 통해 하위 노드 분석 결과를 상위 노드에 즉시 반영해, 잘못된 중간 추론 확산을 줄였다.

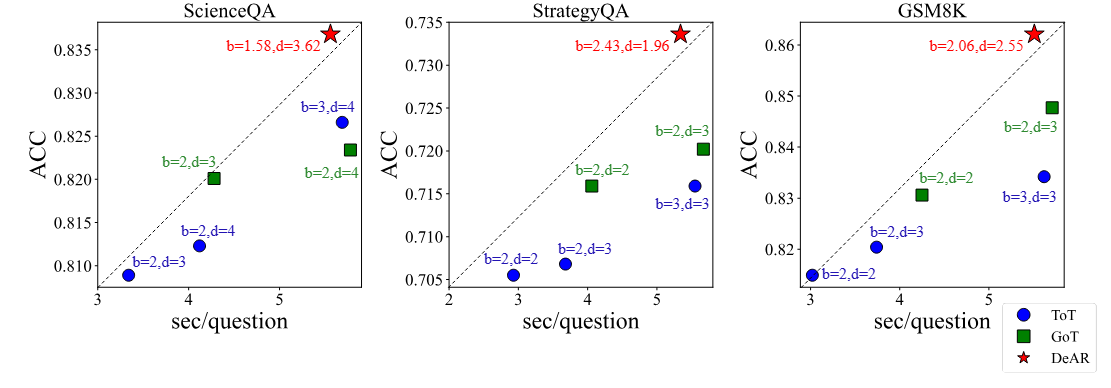

4) 추론 효율: ToT, GoT와 달리 DeAR은 고정된 트리 분기/깊이에 묶이지 않으므로, 문제 유형에 맞춰 더 적은 계산으로 좋은 해답을 낼 수 있었다.

사례 분석

예를 들어, “Janet’s ducks...” 문제를 살펴보면 ToT는 분기 수를 미리 정해두고 탐색해 나가기에, “아침에 3개, 머핀용 4개 사용” 계산을 잘못 반영해 오류가 전파되었다. 반면 DeAR에서는:

1) Q를 2개 하위 질문((q_1, q_2))으로 분해,

2) 각각 “계란 가격?”, “잔여 계란 개수?” 등을 해답으로 작성 후 self-check 진행,

3) 하위 노드가 수정된 정보를 상위 노드에 재반영하여 최종적으로 일일 수익을 “$18”로 정확히 산출했다.

이 예시에서 ToT와 달리 DeAR은 하위 노드 정보가 상위 노드 정보에 즉시 반영되는 “Rethink” 단계를 거치므로, 중간 오류를 교정할 기회를 갖는다.

결론 및 전망

본 논문에서는 LLM 기반 복잡 문제 해결에 있어, “문제 분해(Decompose), 단계별 해답 도출(Analyze), 상위 노드 재검토(Rethink)”의 순환 과정을 거치는 DeAR 프레임워크를 제안했다. 다양한 데이터셋(ScienceQA, StrategyQA, GSM8K)과 여러 LLM(GPT-3.5, LLaMA2, ChatGLM3)에서 실험한 결과, DeAR은 기존 ToT, GoT보다 논리적 일관성과 해답 정확도를 향상시켰다.

앞으로는 확장된 형태의 문제나 더 복잡한 답안을 필요로 하는 도메인(수학, 프로그래밍, 지식 증명 등)에 DeAR을 적용함으로써, LLM의 추론 능력을 한층 강화할 수 있을 것으로 보인다.