Introduction

최근 OpenAI가 선보인 o1 계열 모델은, 테스트 시점에서 더 많은 연산을 허용하며 reasoning을 길게 수행하는 방식으로 복잡한 수학 및 과학 문제를 해결하는 능력을 선보였다. 그러나, 이러한 깊은 사고(deep thinking) 프로세스가 언제나 효율적으로 작동하는 것은 아니라는 관점이 제기되었다. 본 글에서는 o1 계열 LLM들이 underthinking을 나타내는 현상을 소개하고, 이를 완화하기 위한 간단한 기법(Thought-switching penalty)에 관해 논의한다.

Underthinking이란

o1 계열 LLM들은 문제 해결을 위해, reasoning 체인을 구성하고 중간에 여러 아이디어(Thought)로 전환하기도 한다. 하지만 다음과 같은 문제가 포착되었다.

- 과도한 사고 전환: 해결의 실마리를 찾았음에도, 이를 충분히 탐색하지 않고 다른 아이디어로 금세 넘어가서 결과적으로 해답을 못 찾는다.

- 추가 계산 대비 정확도 향상 미비: 오답일 때 오히려 생각이 길어지거나, 여러 번 생각을 바꾸면서, 계산(토큰) 사용량이 크게 증가하나 성능(정확도)은 개선되지 않는 패턴을 보인다.

이를 본문에서는 underthinking이라 칭했다. 즉, 실제로 '깊이 생각하기'보다는 '여러 아이디어를 얕게 시도하기' 때문에 문제가 생긴다.

실험 및 관찰

테스트셋

- MATH500: 고등학교 수학 대회 문제 세트. 난이도를 1~5레벨로 구분.

- GPQA Diamond: 물리, 화학, 생물 등 과학 분야 박사 수준의 어려운 문제.

- AIME: 미국 수학 경시대회 AIME(주로 대수, 수론, 기하 등).

o1 계열 모델

- QwQ-32B-Preview

- DeepSeek-R1-Preview, DeepSeek-R1-671B

모두 o1을 본뜬 이른바 "long chain-of-thought" 공개 모델.

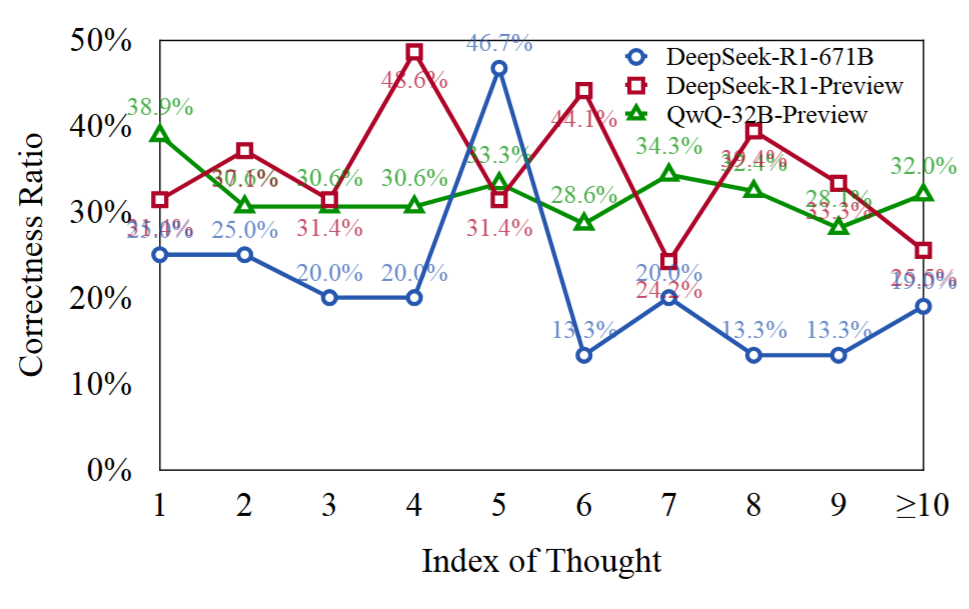

사고 전환 분석

응답을 "alternatively", "another approach" 등으로 명시된 지점에서 분리해보았다. 그 결과:

- 더 어려운 문제일수록 사고 전환 횟수가 증가했다.

- 틀린 답변에서 사고 전환이 정답일 때보다 대폭 많았고, 토큰 사용량도 2~3배 더 컸다.

- 즉, "장황한 토큰 생성"이 "정확도 향상"으로 이어지지 못했다.

Early-stage Thought

실험에 따르면, 틀린 응답 중 상당수가 초반(early stage)에서 이미 맞는 접근법을 제시함에도, 그걸 지속·확장하지 않고 자주 다른 생각으로 옮겨간다는 사실을 발견했다.

Underthinking 척도(Underthinking Metric)

책정한 측도는 다음과 같다:

- UT Score는 "틀린 응답 중 실제로 맞을 수 있었던 부분(첫 올바른 아이디어) 이후로 낭비되는 토큰 비율"로 계산했다.

- 상당수 틀린 해답이, 초반에 정답 접근을 했다가(=맞는 Thought), 이후 무의미하게 토큰만 소모했다.

결과적으로 DeepSeek-R1-671B처럼 대형 모델이 더 성능이 좋지만, 특정 테스크(AIME24 등)에선 underthinking도 함께 줄이지만, 다른 테스크(MATH500-Hard 등)에선 underthinking이 오히려 심해지는 양상이 있었다.

해결: Thought Switching Penalty(TIP)

이 문제를 완화하기 위해, 디코딩 단계에서 특정 전환 토큰에 패널티를 주는 전략을 제안했다.

기본 아이디어

- "alternatively", "another approach" 같은 사고 전환 신호를 갖는 토큰에 대해, logit에서 α만큼 점수를 깎는다.

- α(강도), β(패널티 유지 길이)라는 하이퍼파라미터를 조절해, 모델이 너무 일찍 사고를 바꾸지 않게 한다.

효과

- QwQ-32B-Preview에 적용한 결과, MATH500-Hard, GPQA Diamond, AIME24 등에서 정확도가 2~4%p 정도 상승했고, underthinking 측면에서도 토큰 효율이 개선되었다.

- 추가 모델 파인튜닝 없이 디코딩 레벨만 수정하므로 간단히 적용 가능하다.

결론 및 요약

o1 계열 모델이 보여주는 긴 reasoning trace는, 사실 "얕은 전환"이 중첩되어 비효율적 토큰 사용을 유발하는 underthinking 문제를 종종 드러낸다. 많은 오답에서 초반 아이디어는 맞지만 제대로 발전시키지 않고 다른 사고로 전환해 실패한다.

이 문제를 해결하기 위해서는 Thought Switching Penalty 같은 디코딩 기법을 도입해, 모델이 한 번 잡은 아이디어를 일정 토큰 이상 발전시키도록 하는 방안이 효과적임을 확인했다. 이는 향후 "사람처럼 생각하는" LLM을 만들기 위해 더욱 중요한 과제이며, test-time에서의 단순한 기법 적용만으로도 성능과 reasoning 효율이 모두 개선될 수 있음을 보여준다.

'인공지능 논문 정리' 카테고리의 다른 글

| Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Thought 내용 정리 (0) | 2025.03.09 |

|---|---|

| Diverse Preference Optimization 내용 정리 (0) | 2025.02.10 |

| s1: Simple test-time scaling 내용 정리 (2) | 2025.02.06 |

| DeepSeek-R1: Incentivizing Reasoning Capability in LLMs viaReinforcement Learning 내용 정리 (1) | 2025.02.05 |

| DeepSeek-V3 Technical Report 내용 정리 (0) | 2025.02.03 |