Introduction

최근 Large Language Model(LLM)은 다양한 자연어 처리 및 reasoning 문제에서 우수한 성능을 보이고 있다. 특히 수학 문제 풀이, 과학적 추론, 복잡한 증명 등에 있어 사람 수준 혹은 그 이상의 결과를 보이는 모델이 등장하고 있다. 하지만 이러한 Chain-of-Thought(CoT) 중심의 접근은 여전히 어려운 문제에서 한계를 드러내고 있다. 많은 복잡한 reasoning 작업이 실제로는 반복적 탐색과 검증 과정을 거치는데, 현재의 CoT는 이를 온전히 나타내지 못한다는 비판이 이어지고 있다.

여기서 제안되는 것이 Meta Chain-of-Thought(이하 Meta-CoT)이다. 이는 CoT보다 한 단계 더 확장된 개념으로, 모델이 결과를 도출하는 단계별 추론뿐 아니라 그 과정에서의 검색, 탐색, 중간 검증, 재시도 등의 메타적인 사고 흐름을 명시적으로 표현하거나, 적어도 내부적으로 구현하도록 하려는 시도이다. 이 글에서는 Meta-CoT의 필요성과 이를 달성하기 위한 다양한 아이디어, 그리고 앞으로 풀어나가야 할 연구 과제에 대해 정리한다.

Classical Chain-of-Thought의 한계

CoT와 복잡성

일반적인 CoT 접근은 모델이 질문(question)에 대해 단계적 reasoning 과정을 명시적으로 쓰게 하는 것이다. 그러나 충분히 복잡한 문제(예: 수학 올림피아드 수준)는 단순히 한 방향으로 풀이 과정을 서술한다고 해서 쉽게 해결되지 않는다. 실제 인간 수학자가 문제를 풀 때는 다양한 가설을 시도하고, 잘못된 길이 확인되면 되돌아가(backtracking) 다른 방향을 모색하며, 탐색 중간에 부분 답안을 재검증도 한다. 하지만 현재 CoT 데이터세트나 학습 과정은 문제 푸는 결과물만 linear하게 기록하고, 그 과정의 “비선형적 탐색 과정”은 누락하거나 분리된 형태로 제공하는 경우가 많다.

예를 들어, 고난도 기하학적 증명 문제를 생각해 보자. 일반적으로 사람은 시작에서 한 번에 증명 아이디어를 완성하지 못한다. 도중에 여러 시도를 해보고, 안되면 다시 가정으로 돌아가고, 기하 툴(도형 작도, 보조선 등)을 써서 실험도 해본다. 하지만 전통적 CoT는 정답만 향해 일렬로 쭉 나아가는 방식을 모델이 모사한다. (But, the true data generation process is not auto-regressive) 결과적으로, 어려운 문제에서는 CoT가 문제 해결을 완전히 나타내지 못하고, 모델도 잘못된 길을 차단하거나 바꾸지 못한 채 헛된 계산을 반복하게 된다. (Essentially, to start generating the solution requires that we already know the full approach.) 이런 점이 CoT가 System 2 수준의 reasoning을 완벽히 대체하기 어렵다는 주장의 근거이다.

Meta Chain-of-Thought란 무엇인가

Meta-CoT 개념

Meta-CoT는 간단히 말해, 복잡한 reasoning 과제를 풀기 위해 탐색(Search), 검증(Verification), 재시도(Backtracking) 등의 과정을 메타 단계에서 수행하는 체계를 뜻한다. 보통 우리가 알고 있는 CoT는 문제 풀이 과정을 연속된 하나의 사슬로 기록하지만, 실제 복잡한 문제는 내부적으로 여러 갈래를 시도하고, 어떤 갈래가 막히면 다시 갈래를 바꾸는 형태일 수 있다. 이를 하나의 단순 선형 CoT로 쓰기는 어렵고, 결국 탐색 트리라는 개념이 필요하게 된다. Meta-CoT는 그런 “탐색 트리 + CoT”가 결합된 프로세스라고 볼 수 있다.

왜 Search가 필요한가

수학, 알고리즘, 프로그래밍과 같은 문제에서는 부분적인 해를 시도해 보고, 그 시도가 옳았는지 확인하고, 틀리면 다른 방향을 모색하는 Search 과정이 필수적이다. 일반적으로 Best-of-N (병렬로 N개의 답안을 시도해 보고, 그중 맞는 것을 선택)만으로도 어느 정도 품질이 올라가지만, 실제로는 하위 단계에서 중간부터 잘못된 경로를 버리고, 유망 경로를 깊게 탐색하는 식이 훨씬 효율적이다. 이때 Search가 필요해진다.

이러한 Search는 주로 상태(state)와 행동(action), 보상(reward)으로 구성된 MDP(Markov Decision Process) 혹은 그 변형으로 볼 수 있다. CoT가 한 번에 길게 이어지는 것이 아니라, 매 스텝에서 탐색을 진행하다가 틀렸으면 되돌아가는 방식의 backtracking이 구현되면, 체계적으로 모든 (혹은 유망한) 경로를 살펴볼 수 있다. Meta-CoT는 결국 이런 비선형 search 절차를 모두 담아내거나, 최소한 모델 내부에서 이를 학습해 재현하도록 하는 것을 목표로 한다.

In-Context Search와 Meta-CoT 학습

In-Context Search 시도들

- Self-Correction: 모델이 풀다 틀린 것을 알면 중간에 “다시 생각해보자”라고 하며 스스로 정정을 시도하는 방법이다. 보통은 분리된 검증기가 없으므로, 결과적으로 자기 자신이 먼저 추론한 걸 다시 평가한다.

- 다단계 샘플링(Revision): 한 질문에 대해 답안 하나 내고, 다시 같은 맥락에서 혹시 틀렸을 수도 있으니 다른 답안을 생성하는 식이다. 이 역시 일종의 Search로 볼 수 있다.

- Backtracking CoT: 명시적으로 [BACK]과 같은 토큰으로 "여기서 오류 발생, 이전 단계로 돌아감”같은 단서를 텍스트로 생성하는 사례도 연구되었다. 작은 모델 수준의 실험에서는 효과가 있었고, 수학 문제 정확도가 크게 올라갔다고 알려져 있다.

이러한 시도들은 대체로, 단순 정답만 맞히면 되는 SFT(Supervised Fine-Tuning)로는 얻기 어려운 능력들을 모델에 얹어주려 한다. 하지만 아직까지 분명한 것은, 이 방식들이 어느 정도 효과적이긴 하지만 완벽한 Meta-CoT 수준의 추론 능력을 만들어내는지는 불분명하다는 점이다.

Synthetic Meta-CoT 데이터 생성

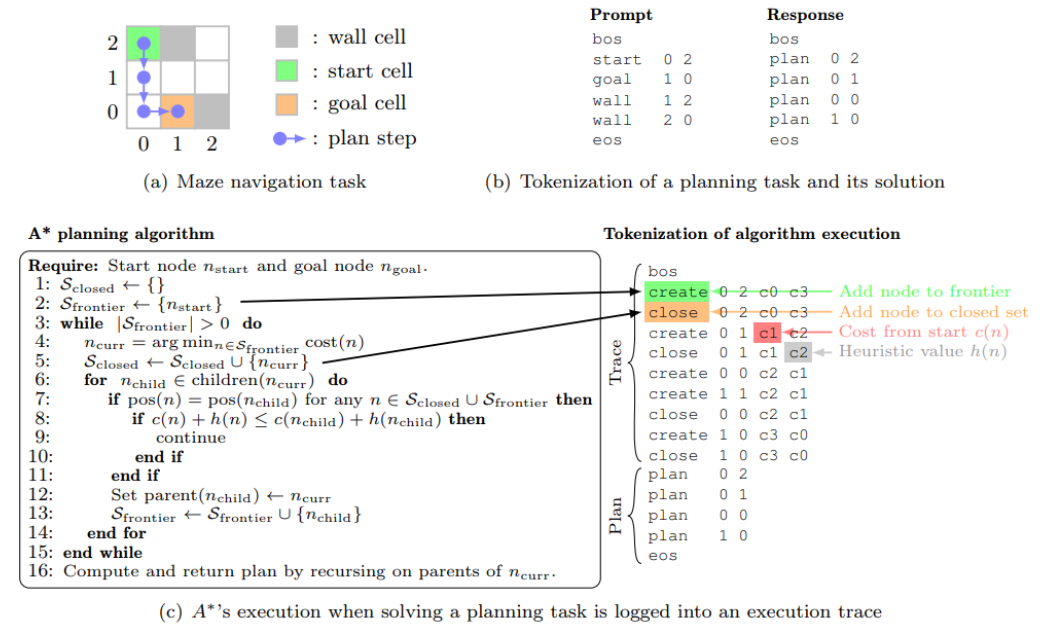

MCTS, A* 등 탐색 알고리즘으로 Search Trace 만들기

Meta-CoT를 모델 내부에서 학습하기 위해, “탐색 트리에서 각 스텝과 그때의 판단(예: 중간 value 추정, 가지치기 결정, backtracking) 등을 모두 텍스트로 기록”해 생성한 학습 데이터를 사용할 수 있다. 예를 들어 Monte-Carlo Tree Search(MCTS) 또는 A* Search를 실제로 돌려서, 중간 state별로 어떤 candidate가 있었고, 어떤 기준으로 선택/배제했는지까지 텍스트화한다. 그런 뒤 해당 trace를 모델이 다음 토큰 예측으로 학습토록 하는 것이다. 그렇게 하면 모델 스스로가 추론 중 유사한 탐색 절차를 in-context로 재현할 수 있게 된다.

Process Reward Model

Search 기반의 synthetic trace를 만들려면 중간 단계에서 가치(value)를 평가해줄 함수(Reward Model)가 필요하다. 보통은 문제 최종 정답만 있으면 Monte-Carlo rollouts 형태로 중간 스텝 값을 추정할 수 있지만, 매우 비용이 크다. 그래서 학습된 Process Reward Model(PRM)을 쓰면, 중간 state만 보고도 “이 state가 옳은 방향인지”를 빠르게 예측하게 되어 탐색 효율을 높일 수 있다. 그러나 PRM의 성능도 여전히 완벽하지 않아, 잘못된 스텝을 높은 점수로 예측한다든지 하는 한계가 존재한다.

Meta-RL과 System 2 Reasoning

Meta-RL 개념

탐색, backtracking 같은 in-context Search를 모델이 스스로 결정할 수 있으려면, 사실상 한 문제에 대해 여러 시도(episode)를 하면서, 전체적으로 최적 해답에 도달하는 것을 최적화하는 메커니즘이 필요하다. 이는 전형적으로 meta-RL이라는 체계에서 연구되어 왔다. 에이전트가 주어진 에피소드 안에서 실험적 행동을 하면서 얻은 보상을 바탕으로 빠르게 최적 정책으로 적응한다는 개념이, LLM의 “여러 코티(CoT) 시도 -> 최종 정답 보상 획득”과 유사하다는 것이다. 실제로 아래와 같은 문제의식이 제기된다.

- 기존 RL(일회성 상태-행동 보상)은 새로운 문제에 대해 탐색 능력을 잘 일반화하지 못한다.

- Meta-RL은 “새로운 문제라도 내부적(메모리 등)에 탐색 기록을 사용해 점진적으로 적응”하는 정책 학습이 목표다.

- 이를 Auto-Regressive Transformer가 메모리로 활용하도록 하면, 바로 in-context exploration과 같아진다.

RL Post-Training

수많은 연구에서 instruction tuning + RLHF는 CoT보다도 성능 향상에 크게 기여했다고 보고했다. Meta-CoT의 학습에도 RL 스텝이 포함될 것으로 예상된다. 즉, MCTS나 A* 같은 명시적 탐색 trace를 만들고, 그걸 대량으로 SFT하면 어느 정도까지는 탐색적 추론을 모사할 수 있지만, 실제로는 On-Policy로 RL을 돌려야 최종적인 수렴이 일어날 가능성이 높다. 특히 모델이 스스로 생성한 잘못된 단계도 계속 탐색하는 식의 자기 시도(self-play)에 가까운 과정을 거쳐야, 배울 수 있는 최적화 지점이 있기 때문이다.

또한 discount factor를 고려한 RL 기법(=검색 단계가 길어질수록 비용 페널티 주기)도 제안된다. 너무 많은 토큰을 써서 답을 맞히는 것이냐, 빠르게 맞히는 것이냐 간의 트레이드오프가 존재하기 때문이다.

종합적 파이프라인

메타적 reasoning을 위한 전체 파이프라인은 대략 다음 흐름을 가진다.

- Instruct Tuning: 적당한 규모의 meta-coT 예시(검색 트레이스, backtracking, verifier step 등)를 담은 synthetic 데이터를 생성한다. 그리고 이를 이용해 SFT(Instruction Tuning)를 수행한다.

- RL Stage: On-Policy 데이터(에이전트=모델이 실제로 생성한 trace)를 기반으로 Monte-Carlo search나 MCTS, 또는 step-level policy gradient를 이용해 업데이트한다. 이 때 Process Reward Model(PRM) 혹은 공식 답안을 이용해 보상을 측정한다.

- 추가 Techniques: discount factor, verifier accuracy 개선, 메타-RL 기법(에이전트가 in-context에서 탐색 후 마지막 step 보상만 최적화) 등을 적용해 모델이 “효율적이고 고도화된” search 능력을 자동으로 익히도록 유도한다.

남은 과제 및 전망

- Faithful Reasoning: 단순히 정답을 맞히는 것 이상으로, 정말 타당한 논리 과정을 코티에서 보장할 수 있는가. 보통은 정답이 있으면 된다 해도, 실제로는 증명이나 해석의 정확성도 필요해진다.

- Open-Ended Verification: 수치형 답이 아닌 증명, 글쓰기 등에서 메타코티 검색 검증을 어떻게 자동화할 것인가. 편의상 수학적 형태나 프로그래밍 테스트처럼 명백히 검증 가능하면 문제 없지만, 일반 오픈엔드에는 별도 human label이나 추가 연구가 필요하다.

- Scaling Laws: 추론과 검색이 결합된 모델이 모델 사이즈·학습 데이터·탐색 토큰 등을 늘릴 때 어떤 성능 스케일링을 보이는지 명확히 파악되지 않았다. RL, SFT 각각의 기여도도 향후 연구 대상이다.

- 결합된 Search 2: LLM 내부에 하나의 검색이 있고, 그 검색을 또 바깥에서 Search로 감싸는 “이중” 혹은 “meta” search 구조도 가능할까. 이론상 더 효율적이고 강력한 모델이 될 수도 있지만, 실제로 구현이나 학습이 어려울 수 있다.

- Tool Integration: 외부 계산(계산기, Python, Wolfram) 등을 호출하는 tool-integrated reasoning과 Meta-CoT가 결합되면, 훨씬 적은 토큰으로도 복잡한 문제를 해결할 수 있다는 결과가 일부 보고되었다. 이 부분을 확장해 “효율적이고 강력한 LLM reasoner”를 구축하려면 추가 연구가 필요하다.

결론

전통적인 Chain-of-Thought 방식은 간단한 reasoning 문제 해결에는 큰 도움이 되었지만, 더 복잡한 문제(수학 올림피아드, 복잡 과학적 증명 등)에서는 내부적 탐색과 재검증 과정이 부족하다는 점이 지적된다. Meta Chain-of-Thought는 이 한계를 극복하기 위해 탐색, 검증, backtracking 등 실제 사람의 사고 방식을 반영하는 구조를 모델 내부 또는 생성물에 명시적으로 도입하려는 아이디어다.

구현 방법으로는 탐색 기반 synthetic data 생성(MCTS, A*) + SFT, 그리고 on-policy reinforcement learning(Meta-RL)을 결합하는 파이프라인이 소개되었다. 이를 통해 LLM이 스스로 검색을 내재화하여, 필요 시 더 오래 탐색하고, 잘못된 경로에서 돌아가며, 스스로 답안을 검증·개선하는 System 2 의 추론적 사고를 수행하도록 만드는 것이 궁극적인 목표다.

아직은 큰 모델이나 일반적인 reasoning 작업에서 “진정한” Meta-CoT가 완성되었다고 보기 어렵다. 다만 중소형 모델과 특정 태스크(간단한 게임, 수학 퀴즈 등)에서는 promising한 결과가 보고되고 있다. 또한 실제로 OpenAI o1, DeepSeek R1 등 일부 최첨단 모델이 비선형 탐색 흔적을 보인다는 분석도 있다. 앞으로는 더 큰 규모의 데이터세트(예: Big MATH)와 대규모 인프라, 정교한 RL 기법, 그리고 tool integration 등을 결합해, Meta-CoT를 성숙시켜갈 것으로 기대된다.

결국 Meta-CoT를 통해 “단순 답안 맞히기”를 넘어서는 고차원적인 추론 패턴이 구현된다면, LLM이 사실상 인간 수준의 사고 체계를 상당 부분 재현할 가능성이 열린다. 이는 향후 대규모 연구 커뮤니티의 공동 노력으로 풀어야 할 핵심 과제가 될 것이다.

'인공지능 논문 정리' 카테고리의 다른 글

| Diverse Preference Optimization 내용 정리 (0) | 2025.02.10 |

|---|---|

| Thoughts Are All Over the Place: On the Underthinking of o1-Like LLMs 내용 정리 (0) | 2025.02.07 |

| s1: Simple test-time scaling 내용 정리 (0) | 2025.02.06 |

| DeepSeek-R1: Incentivizing Reasoning Capability in LLMs viaReinforcement Learning 내용 정리 (0) | 2025.02.05 |

| DeepSeek-V3 Technical Report 내용 정리 (0) | 2025.02.03 |